Intervista. A Mamme Magazine l’esperto parla dell’uso dell’intelligenza artificiale a scuola e dei rischi per la privacy delle nuove generazioni

di Manuela Vacca

“Da quando è arrivata ChatGpt non leggo altro che improperi ‘contro’ questa intelligenza artificiale”. Non ci sta Nereo De Cesari, pseudonimo di un apprezzato specialista di cybersicurezza e attento osservatore delle relazioni tra reale e uso della tecnologia. Troppe facilonerie, troppe semplificazioni dettate dalla tendenza alla polarizzazione del nostro contemporaneo che tende a virare la complessità multicolore a una mesta alternanza tra bianchi e neri.

Sentito da Mamme Magazine a proposito degli studenti che usano l’intelligenza artificiale per finalità non scolastiche e sul pericolo di annesso controllo automatizzato, l’esperto – che è anche pregevole firma in queste pagine – non cita direttamente Alan Turing ma potrebbe benissimo farlo. “Facciamo con le macchine quello che facciamo con gli esseri umani: assumiamo l’educata convenzione che tutti coloro che dimostrano esternamente una forma di pensiero, pensino veramente”, disse una volta il matematico fondatore dell’informatica.

Insomma De Cesari ritiene doveroso fare una premessa. “Come sempre tengo a dire che informarsi, leggere, imparare, sono il primo metodo per creare una mente critica – spiega -. Posto che ChatGpt è solo un assistente tipo Alexa, ma più evoluto e potente, non fa altro che riflettere il comportamento e il carattere dell’utente che lo interroga, salvando i prompt con le varie richieste per generare un profilo comportamentale adeguato e sempre in evoluzione. Leggendo il contratto di ChatGpt queste informazioni sono chiare, lapalissiane. Quindi accusare lo strumento di essere pericoloso o dannoso, si riduce nel dare la colpa alla pistola per l’uccisione di un uomo. Quello che si è perso di vista è proprio il concetto di intelligenza artificiale a scapito di un servitore di espressioni idiomatiche scritte (o dette) con lo stesso tono dell’utente che le ha richieste”.

Quindi, nel caso di un adolescente che faccia domande delittuose all’Ia, come nell’ormai celebre caso del 13enne arrestato negli Stati Uniti?

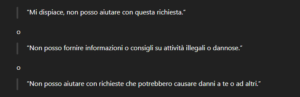

“Non mi meraviglia che un ragazzino di 13 anni chieda a ChatGpt come uccidere un compagnetto di classe, mi meraviglia tutto lo scalpore mediatico che ha avuto. In fondo è meno grave di una sparatoria a scuola, no? Eppure si demonizza ChatGpt ma non la Smith&Wesson. Eppure ChatGpt, sono certo, abbia risposto così:

Però ora i minori vengono spiati online: che cosa sta succedendo nelle scuole americane?

“Negli Usa c’è una filiera industriale della student surveillance spinta da timori reali. Funziona, ma costa privacy e libertà d’espressione. In Europa il Gdpr mette freni seri: qualcosa si può fare per la sicurezza, non la sorveglianza totale. Scuole e distretti comprano piattaforme tipo Gaggle, GoGuardian, Bark, Securly, Lightspeed ecc. Queste leggono/analizzano i Chromebook e gli account Google Workspace / Microsoft 365 Education gestiti dalla scuola, la navigazione su reti scolastiche, file, email, chat e documenti scolastici (Drive/OneDrive) con parole chiave su violenza, armi, autolesionismo, pornografia, droghe, bullismo. Cosa succede quando scattano alert? Gli algoritmi inviano una segnalazione agli amministratori scolastici (e talvolta “analisti” del vendor) valutano la notifica e inviano una segnalazione a genitori, preside, counselor. Nei casi seri coinvolgono la polizia. In America però, c’è una normazione differente, a volte è federale, altre volte è relativa ai singoli stati o alle contee”.

Però si tratta di studenti all’interno di ambienti educativi. Che fine fa la privacy per questi esseri umani in crescita?

“Esiste il Cipa, Children’s Internet Protection Act, che spinge i distretti che vogliono sussidi “E-Rate” a filtrare contenuti. Molti traducono filtrare in monitorare. Il Ferpa tutela i “record educativi”, ma lascia ampio margine ai distretti su strumenti di sicurezza. In pratica: sui device/account della scuola lo studente ha un’aspettativa di privacy ridotta. Fuori dalla scuola e su device personali la faccenda è più complessa, ma quando c’è un ipotetico reato/minaccia, le scuole si coprono coinvolgendo le forze dell’ordine. Questo però può far incorrere in falsi positivi (ironia scambiata per minaccia) o in chilling effect, cioè gli studenti si autocensurano. Oppure in opaca conservazione dei dati,e sicurezza usata come cavallo di Troia per sorveglianza di massa di basso impatto. Che poi il discorso è sempre lo stesso: sicurezza contro libertà. Prevenire un suicidio o una sparatoria non è uno scherzo: qui nessuno fa il purista. Ma il monitoraggio generalizzato di testi, chat e documenti sugli adolescenti crea danni collaterali reali. Sarebbero ragionevoli filtri di rete per bloccare categorie illecite/estreme? Facciamo due esempi pratici su due parole prese a caso: omicidio e attentato. Se nel form di ricerca di google inserissi il prompt ‘omicidio Franz Ferdinand’ e ‘attentato Franz Ferdinand’ scatterebbero gli alert? Se ci fosse una revisione umana probabilmente no, ma lo strumento non capisce che la ricerca sulla Grande Guerra è molto probabilmente lecita. Può avere senso un’allerta mirata su parole chiave a rischio vita con revisione umana qualificata . Invece non è etico un keylogger, cioè un software che registra ciò che digiti sulla tastiera, come la lettura sistematica di documenti/chat, sorveglianza h24 e riuso dei dati per la profilazione. Anche in Usa molte organizzazioni civili lo contestano”.

Torniamo in Europa: abbiamo il Gdpr, il Regolamento Generale sulla Protezione dei Dati. Potrebbe verificarsi qualcosa di questo tipo?

“In Europa si può fare molto meno e il processo è molto più trasparente. D’altronde il Gdpr parla chiaro: su necessità e proporzionalità: niente sorveglianza generalizzata. Si giustifica un filtro di rete, si giustifica un blocco dei contenuti (pornografia, gambling, politica) ma un monitoraggio continuo di contenuti personali è difficile da difendere. Poi minimizzazione e scopi: si raccolgono solo i dati strettamente necessari per sicurezza ed è vietato riusarli per altro (valutazioni, disciplina non correlata, marketing). Ancora trasparenza: informativa chiara a studenti/genitori su chi vede e cosa vede e ovviamente tempi di conservazione brevi, e valutazione d’impatto quasi sempre obbligatoria con il responsabile del trattamento dati convolto e misure tecniche definite (ruoli, logging, encryption). Per l’articolo 22 non sono possibili decisioni solo automatizzate con effetti significativi sull’alunno, quali per esempio una segnalazione automatica alla polizia, senza una revisione umana. E poi i dispositivi personali e il controllo fuori dall’orario scolastico sono tabù, salvo casi eccezionali normati e l’autorizzazione della magistratura”.

Abbiamo un approccio totalmente differente, dove la privacy è un valore e abbiamo un diverso sistema educativo.

“Il Garante della privacy italiano è storicamente molto rigido sul proctoring, ossia sulla sorveglianza di esami a distanza per garantirne l’integrità e prevenire che gli studenti imbroglino, e sugli strumenti intrusivi, anche nel caso di didattica a distanza. Un sistema alla “leggo tutti i documenti/email degli studenti e segnalo” avrebbe altissime probabilità di essere bocciato o ristretto pesantemente. Dobbiamo però soffermarci su un aspetto non da poco, ovvero la violenza che da sempre contraddistingue gli ambienti giovanili in Usa. Molte di quelle che noi percepiamo come restrizioni sono “arrivate” per cercare di arginare quel fenomeno tutto americano delle sparatorie nelle scuole, per cercare di prevenire certi atteggiamenti. C’è inoltre da sottolineare che in moltissime aree urbane più o meno degradate, il fenomeno violento persiste ancora, mentre negli istituti in cui si sono presi provvedimenti di monitoraggio il fenomeno sembra essere diminuito. Un’analisi approfondita del fenomeno stesso includerebbe di indagare sulla facilità di procurarsi un’arma ma si è semplicemente deciso che perdere un po’ di privacy fosse il miglior metodo per garantire sicurezza. Forse noi europei lo percepiamo molto meno e le nostre strutture educative sono meno soggette a stimoli sociali ed educativi negativi. Inoltre, abbiamo dalla nostra parte delle legislazioni favorevoli al concetto di privacy. A mio avviso le cose stanno per cambiare per l’esistenza di una marea di aziende private che offrono servizi di sicurezza mobile”.

Foto: Pixabay

Leggi anche: Adolescenza, quando si chiede a Chatgtp come compiere un atto estremo